유럽연합의 AI Act는 인공지능 기술의 안전성과 신뢰성을 확보하기 위해 제정된 최초의 포괄적 법안으로, AI 시스템의 위험도를 기준으로 규제 수준을 차등화하는 구조를 갖는다. 이 글은 AI Act의 주요 내용과 규제 체계, 그리고 산업과 사회에 미치는 영향을 분석한 후, 현대적 시점에서 시사점과 통찰을 제시한다.

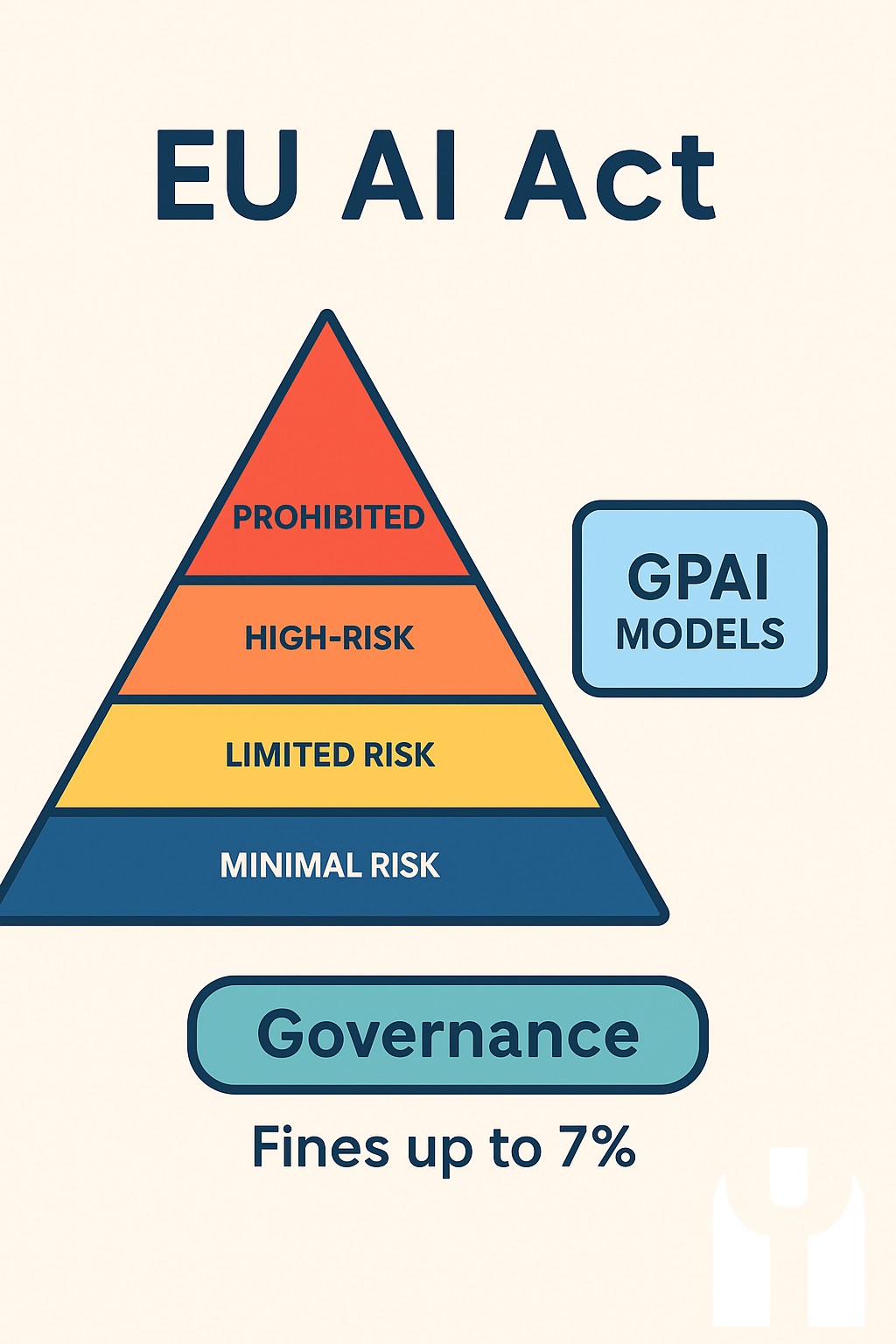

AI Act는 인공지능 시스템을 위험 수준에 따라 ‘금지된 AI’, ‘고위험 AI’, ‘제한적 AI’, ‘최소 위험 AI’로 구분한다. 고위험 AI에는 공공안전, 인권, 핵심 인프라 등 사회적 중요 영역에 적용되는 시스템이 포함되며, 엄격한 사전 인증과 투명성, 책임성 확보가 요구된다. 예를 들어, 의료기기나 교통 관련 AI는 고위험 분류에 속한다. 반면, 금지된 AI는 인간의 자유를 침해하거나 조작하는 시스템으로서 명백히 배제된다. 이를 통해 AI 사용의 법적 안정성과 윤리적 기준을 동시에 확보하고자 한다.

AI Act는 기술 발전과 규제의 균형을 목표로 하며, 기업과 개발자는 AI 시스템 개발 초기 단계에서부터 위험 평가와 데이터 관리, 성능 검증을 의무적으로 수행해야 한다. 특히, AI 시스템의 학습 데이터 편향성 검토와 결과의 설명 가능성을 강화하는 규정이 포함되어 있어, 투명성과 공정성을 제고한다. 이와 같은 규제는 유럽 내 AI 산업의 신뢰도를 높이는 한편, 글로벌 시장에서의 경쟁력 확보에도 기여할 전망이다.

한편, AI Act는 회원국 간 규제 통일성을 추구하면서도, 유연성을 유지하기 위해 일부 분야에 대해서는 국가별 추가 규제를 허용한다. 이는 다양한 산업 특성과 기술 발전 속도를 고려한 조치로, 규제의 실효성을 높인다. 그러나 중소기업이나 스타트업에 대한 부담 증가 우려도 제기되고 있어, 지원 정책과 규제 완화 방안이 병행되어야 한다는 의견이 많다.

"AI Act aims to ensure that AI systems placed on the EU market and used in the Union are safe and respect existing law on fundamental rights and Union values"라고 명시된 원문은 "AI Act는 EU 시장에 출시되고 연합 내에서 사용되는 AI 시스템이 안전하며 기본권과 연합 가치를 존중하도록 보장하는 것을 목표로 한다"로 번역할 수 있다. 이는 법안의 근본 취지를 명확히 하며, 기술 혁신과 인권 보호의 조화를 강조한다.

결론적으로, AI Act의 성공적인 시행을 위해서는 첫째, 기업과 개발자들은 AI 시스템 설계 초기부터 위험 평가 및 데이터 관리를 체계적으로 수행해야 한다. 둘째, 규제 당국은 중소기업 지원과 규제 부담 완화를 위한 정책적 보완책을 마련해야 한다. 셋째, 유럽연합은 국제 협력을 통해 AI 규제 표준화에 앞장서야 하며, 넷째, AI의 투명성과 설명 가능성 확보에 기술적·제도적 노력을 병행해야 한다. 마지막으로, 시민과 사용자들의 AI 이해도 증진과 권리 보호를 위한 교육 및 홍보 활동도 강화되어야 한다.

참고문헌

European Commission. (2021). Proposal for a Regulation laying down harmonised rules on artificial intelligence (Artificial Intelligence Act). https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A52021PC0206

NEOP/X

NEOP/X