인공지능(AI) 투명성을 위한 표준, 프레임워크, 법제도에 관한 이 글은 다양한 국제기구와 국가별 규제 현황을 분석하여 AI 시스템의 투명성 확보를 위한 체계적 접근 방법을 탐구한다. AI의 복잡성 증가와 사회적 영향력 확대에 따라 투명성은 신뢰 구축과 책임 소재 명확화에 핵심적 요소로 대두되고 있다. 본문에서는 AI 투명성 관련 표준과 프레임워크의 개발 동향, 주요 법률 및 정책 사례, 투명성 구현을 위한 기술적·관리적 도구, 그리고 향후 개선 방향에 관해 체계적으로 정리한다.

첫째, AI 투명성 표준과 프레임워크 개발 동향에 대해 다룬다. 국제표준화기구(ISO)와 국제전기기술위원회(IEC)는 AI 거버넌스와 투명성에 관한 표준을 공동 개발 중이며, IEEE는 AI 윤리와 투명성 원칙을 포함한 가이드라인을 제시한다. “Transparency in AI systems requires clear documentation and explainability mechanisms to ensure accountability”라는 원문은 “AI 시스템의 투명성을 위해서는 명확한 문서화와 설명 가능성 메커니즘이 책임성을 보장하는 데 필요하다”라고 번역할 수 있다. 이러한 표준은 AI 알고리즘의 의사결정 과정과 데이터 처리 방식을 공개하는 것을 핵심으로 삼는다. 프레임워크는 이해관계자별 요구사항을 반영하여 투명성 수준을 단계별로 규정하며, 기업과 개발자가 준수 가능한 가이드라인을 제공한다.

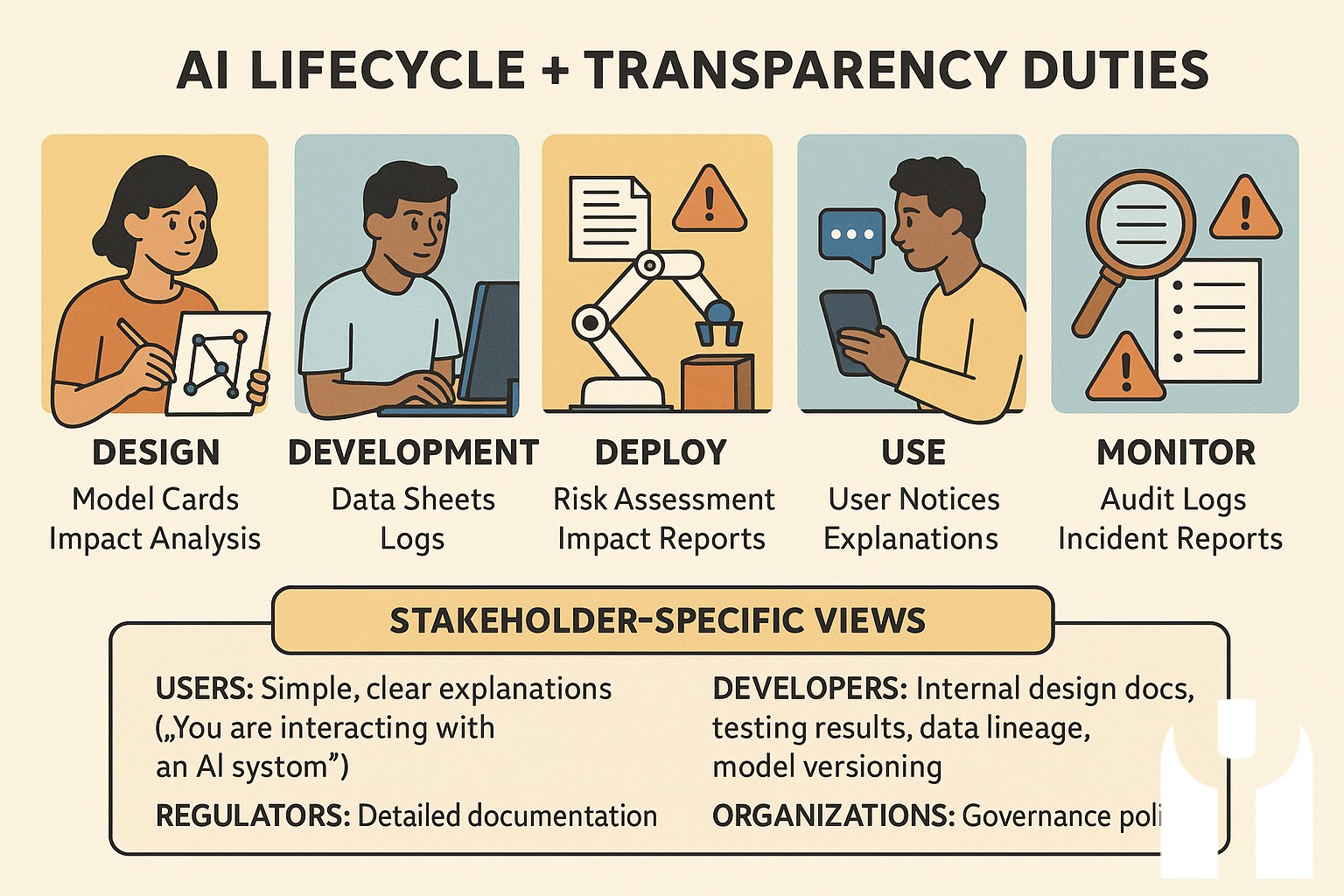

둘째, AI 투명성 관련 법률과 정책 사례를 분석한다. 유럽연합(EU)의 인공지능법(AI Act)은 위험 기반 접근법을 채택하여 고위험 AI 시스템에 대해 엄격한 투명성 및 설명 의무를 부과하고 있다. 미국은 주별로 다양한 AI 규제가 존재하며, 연방법 차원에서의 통합 규제는 아직 미흡한 실정이다. 중국은 AI 안전과 투명성에 관한 국가 표준을 발표하여 산업 전반에 적용하고 있다. 이러한 법률들은 AI의 투명성을 확보하기 위해 개발 단계부터 운영, 사후 관리까지 전 주기를 규율하는 특징을 보인다. 특히, 데이터 편향성과 알고리즘 불투명성 문제를 해소하기 위한 공개 요구가 공통적으로 포함된다.

셋째, AI 투명성 구현을 위한 기술적 및 관리적 도구를 소개한다. 설명 가능한 AI(XAI) 기술은 복잡한 모델의 의사결정 과정을 인간이 이해할 수 있는 형태로 변환하며, 데이터셋과 모델의 투명한 관리 체계는 신뢰성 확보에 기여한다. 또한, 감사 로그 기록, 자동화된 리포팅 시스템, 독립적 검증 프로세스는 법적 요구사항 충족과 지속적 모니터링을 가능하게 한다. 관리적 측면에서는 투명성 정책 수립, 이해관계자 커뮤니케이션 강화, 윤리 위원회 설치 등이 포함된다. 이와 함께, “Effective AI transparency requires integration of technical tools and organizational processes”라는 문장은 “효과적인 AI 투명성은 기술적 도구와 조직적 프로세스의 통합을 필요로 한다”라고 해석된다.

넷째, 향후 AI 투명성 향상을 위한 과제를 검토한다. 표준과 법률 간 일관성 부족, 국제적 협력 미비, 투명성 수준 평가 기준 부재가 주요 문제로 지적된다. 또한, AI 기술 발전 속도를 따라잡기 위한 신속한 규제 개정과 프레임워크 보완이 요구되며, 사용자 중심 투명성 강화와 프라이버시 보호 간 균형점 모색도 중요한 과제로 남아 있다. 이를 위해 다학제적 연구와 이해관계자 간 지속적 대화가 필요하다.

이 글에서 제시하는 도구는 AI 시스템 투명성 평가 매트릭스, 법률 준수 체크리스트, 설명 가능성 검증 툴로 구성된다. 입력값으로는 AI 모델 구조, 데이터셋 특성, 운영 환경, 관련 법률 문서가 포함되며, 기대 출력값은 투명성 평가 결과 보고서, 준수 수준 점검 결과, 개선 권고안이다. 품질 점검용 QA 체크리스트는 문서화 완성도, 설명 가능성 수준, 법률 적합성, 이해관계자 피드백 반영 여부를 포함한다. 문제 발생 시 롤백 계획은 이전 버전의 투명성 문서 복구, 설명 메커니즘 재구축, 법률 자문 재진행을 통해 안정성을 확보한다.

결론적으로, AI 투명성 확보는 신뢰 구축과 사회적 수용성 증진에 필수적이며, 이를 위해 표준과 프레임워크의 체계적 개발, 법제도의 명확한 적용, 기술적·관리적 도구의 통합 운영이 요구된다. 실무적으로는 첫째, 국제 및 국내 표준과 법률을 지속적으로 모니터링하고 최신화해야 한다. 둘째, AI 개발 초기 단계부터 투명성 요건을 반영하여 설계 및 문서화를 체계화해야 한다. 셋째, 설명 가능성 기술과 감사 체계를 도입하여 운영 중 투명성을 지속적으로 점검해야 한다. 넷째, 조직 내 윤리 위원회 설치와 이해관계자와의 커뮤니케이션 강화로 사회적 책임을 다해야 한다. 다섯째, 규제 변경과 기술 발전에 신속히 대응할 수 있는 프로세스를 마련하여 안정적 AI 운영 기반을 확보해야 한다.

이 글은 AI 투명성 확보에 관한 표준, 프레임워크, 법제도를 통합적으로 분석함으로써 실무 적용 가능성을 높이고 향후 정책 및 기술 발전 방향을 제시한다. AI 신뢰성 강화와 법적 책임 확보를 위한 체계적 접근을 고민하는 마케팅 분석가에게 시사점을 제공한다.

NEOP/X

NEOP/X