EU HLEG의 「신뢰할 수 있는 AI를 위한 윤리지침」(Ethics Guidelines for Trustworthy Artificial Intelligence)은 유럽연합의 고위급 전문가 그룹(EU High-Level Expert Group on AI)이 2019년에 발표한 문서로, 인공지능 기술의 개발과 활용에 있어 인간 중심(human-centric), 윤리적, 투명한 접근을 촉진하기 위한 핵심 원칙과 실행 가이드를 제공한다. 이 지침은 시민의 기본권을 보장하며 공공의 신뢰를 구축하는 데 목적이 있다.

지침에서 사용되는 중요한 핵어계 중 하나인 ‘신뢰(trust)’는 라틴어 ‘fides’에서 유래하며 ‘신념’이나 ‘신뢰할 수 있음’을 의미한다. 원래는 종교적, 사회적 맥락에서 공동체의 결속을 의미했으나, 현대에 들어서는 기술, 경제 관계 속에서 필수적 요건으로 간주된다. 다시 말해, 인간이 기술에 의존하려면 기술이 예측 가능하고 안정적으로 작동해야 하며, 윤리적 기준을 충족한다는 확신을 가져야만 한다. 여기서 ‘윤리(ethics)’는 그리스어 ‘ethos’에서 유래하며 습관이나 성격을 뜻했고, 철학자 아리스토텔레스는 이를 공동체의 좋은 삶을 지향하는 원칙으로 격상시켰다. ‘신뢰할 수 있는 윤리적 AI’의 개념은 이러한 철학적 배경 아래에서 인공지능의 실천적 방향성을 제시하려 한다.

한자로 윤리(倫理)는 ‘윤(倫)’과 ‘리(理)’에서 비롯된다. ‘윤(倫)’은 ‘서로 어울리다’ 혹은 ‘인간 관계 속의 도리’를 뜻하며, ‘리(理)’는 ‘이치’ 혹은 ‘이성’을 뜻한다. 즉, 윤리란 인간과 인간 사이의 질서 있는 관계를 다스리는 이치로 해석할 수 있다. 여기에 ‘신뢰할 수 있는(可信)’이 더해지면, 기술이 인간 사회 속에서 그 역할을 수행할 때, 기본적인 도덕성과 책임성을 기반으로 한다는 원칙이 명확해진다. AI가 인간과 함께 ‘어울려 작동’하면서도 ‘이치에 맞게’ 움직여야 한다는 것을 이 한자어는 은유적으로 상징한다.

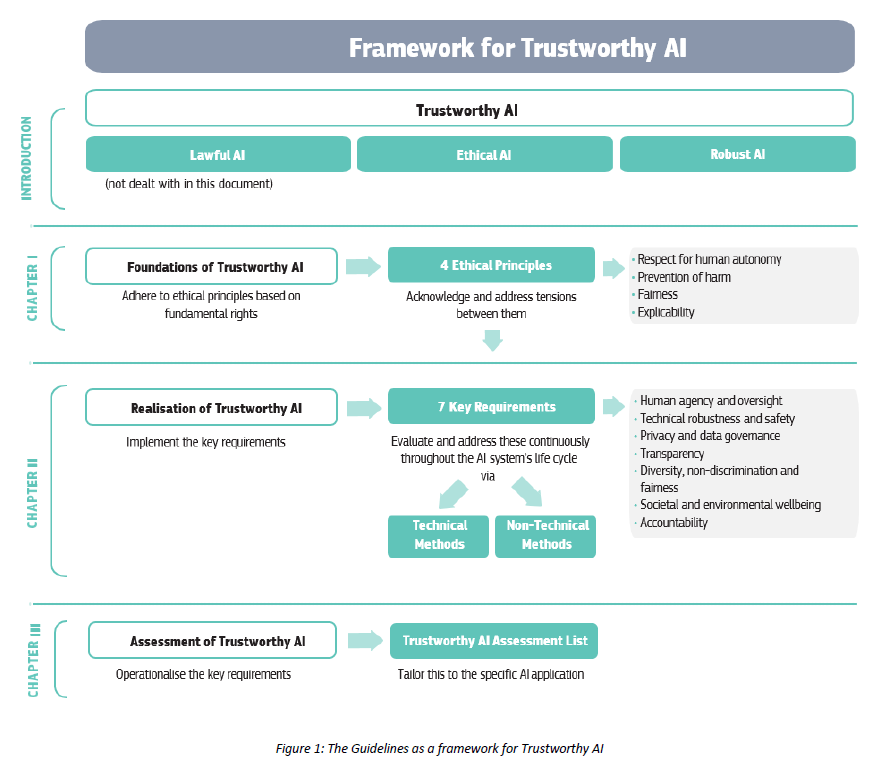

HLEG는 유럽연합 집행위원회(European Commission)가 2018년 4월 발표한 AI 전략의 일환으로 구성된 전문가 그룹으로, 학자, 기업인, 시민단체 활동가 약 52인으로 구성되어 있다. 이들은 기술 결정권자와 시민 간의 간극을 줄이고, 법적 공백을 메우기 위한 자문 역할을 수행했다. 2019년 4월, 이들은 7개의 핵심 윤리 원칙을 중심으로 한 최종 지침을 발표했다: 인간 자율성의 존중, 예방 조치, 기술적 견고함, 프라이버시와 데이터 거버넌스, 투명성, 다양성 비차별 및 공정성, 그리고 사회적·환경적 복지이다. 이 문서는 법적 구속력은 없지만, 세계적으로 윤리적 AI 개발 방향성을 제시한 대표적 문건으로 평가받는다.

당시 지침 발표는 자율주행차의 사고, 감시 AI의 남용, facial recognition의 편향 등 사회적으로 AI의 위험성과 부작용이 급부상하던 시기와 맞물린다. 특히, 미국 기업 중심의 AI 산업에 대한 유럽의 독자적 대응으로서, 시민 중심 기술철학에 대한 뚜렷한 입장 표명이기도 했다. 유명한 일화로는, 지침 초안 발표 직후 Google과 Microsoft 등 미국의 테크기업들이 이 지침의 초점—특히 인간 중심성과 책임성 부분—에 호의적인 반응을 보였음에도, 실제 구현을 위한 내부 가이드라인 수정에는 상당한 시간이 필요했다고 알려져 있다. 이는 기술 산업과 공공 규범 사이의 간극을 잘 보여주는 사건이다.

최근 기사 및 연구동향을 보면, AI 윤리 및 거버넌스 연구에 있어 HLEG의 지침이 준 영향은 상당하다. 예컨대, Floridi et al.(2020)은 해당 지침이 인공지능 윤리 담론의 토대를 바꿔놓았으며, 특히 ‘신뢰’의 개념을 중심축으로 가져온 것을 높이 평가했다 (Floridi, L., Cowls, J., Beltrametti, M., et al., 2020. AI4People—An Ethical Framework for a Good AI Society: Opportunities, Risks, Principles, and Recommendations. Minds and Machines, 30(1), pp.1–24). 또한 최근 2023년에 발표된 논문들에서는 이 지침이 유럽 AI법(AI Act) 초안 및 표준화 이니셔티브의 규범적 템플릿이 되고 있음을 분석하였다. 이처럼 윤리 지침이 단순한 선언적 의미를 넘어서 정책 및 산업 실행에까지 영향을 미치고 있다는 것은, 향후 글로벌 거버넌스에 있어 중요한 참고 사례임을 시사한다.

실용적인 활용 방안에 있어, 이 지침은 기업과 정부 부문에서 AI 시스템 설계 시 체크리스트로 작용할 수 있다. 기업은 AI 제품 개발주기 전체에 걸쳐 해당 7대 원칙을 적용하여, 소비자 신뢰를 확보하고 규제 리스크를 사전에 줄일 수 있다. 예를 들어, 의료 진단 AI를 개발하는 스타트업이 윤리 점검 프레임워크 내장 프로토콜을 도입함으로써, 실제 임상시험 과정에서 예기치 못한 재식별 위험이나 데이터 편향 문제를 예방할 수 있다. 이는 사회적 수용성과 상업적 성공 모두에 기여할 수 있는 전략적 요소로 작동한다. 또한 정부는 공공부문 AI 도입 시 투명성과 책무성을 강조함으로써 민주주의와 기술 권력 사이의 적절한 균형을 조성할 수 있다.

종합적으로 볼 때, EU HLEG의「신뢰할 수 있는 AI를 위한 윤리지침」은 단지 기술 윤리를 선언하는 차원을 넘어선 실행 지향적 틀을 제시하고 있다. 이는 인공지능이 공공의 신뢰를 기반으로 선용되려면 기술적 성능만이 아니라 인권, 정의, 공공선 등 가치 중심의 사유가 병행되어야 한다는 사실을 강하게 주장한다. 결국 인간 존재가 기술 체계 내에서 중심성(human agency)을 지켜내려는 집단적 노력의 산물이며, 이는 글로벌 AI 체제 전환기에 마주해야 할 윤리적, 철학적, 정책적 시금석이 될 것이다. 유럽에서 시작된 이 흐름은 이제 전 세계적 논의로 확장되며, AI가 누구를 위한 기술인지를 되묻게 만드는 강력한 사유의 틀이 되었다.

NEOP/X

NEOP/X