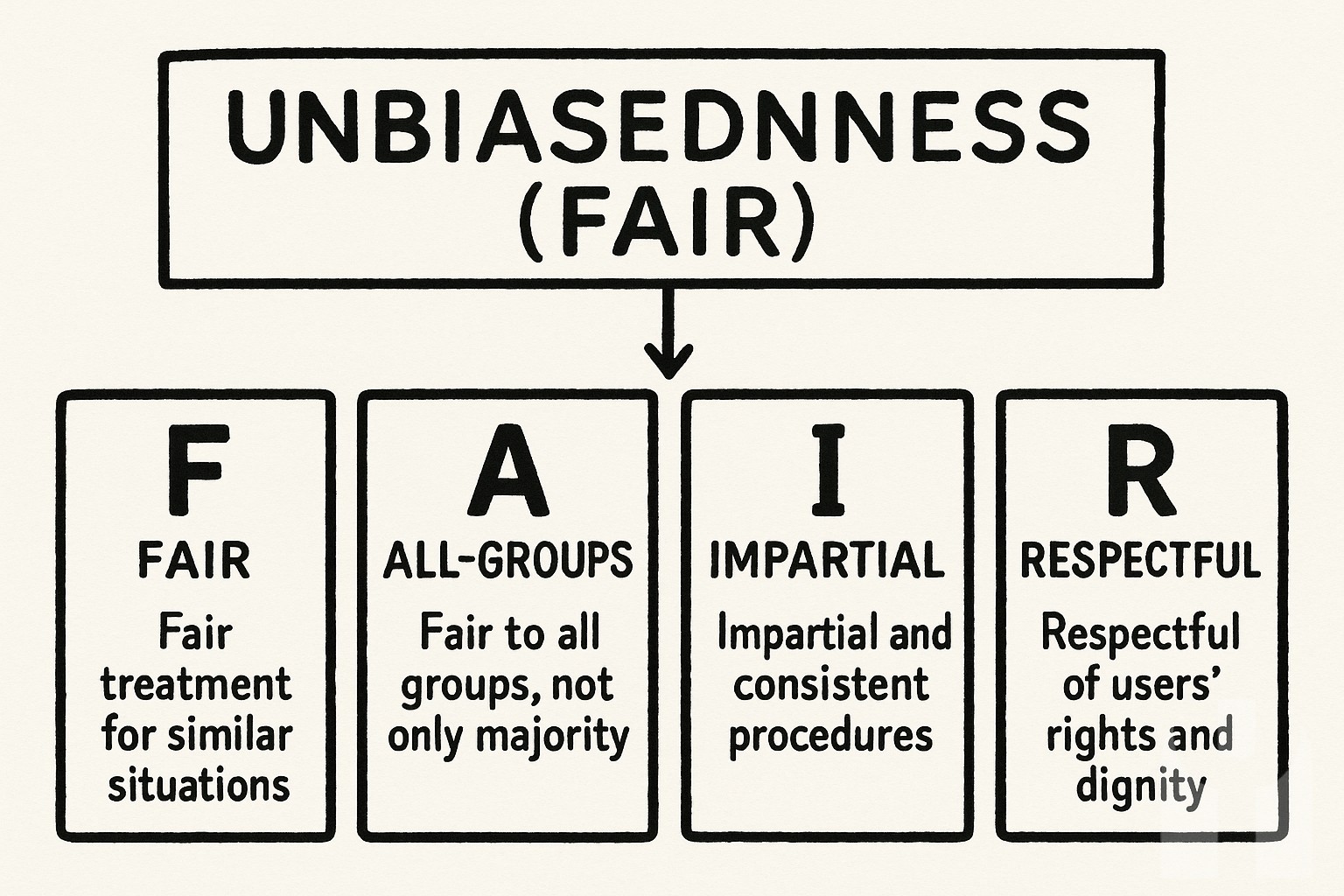

생성형 AI의 공정성 윤리에 관한 연구는 디지털 마케팅 환경에서 점차 중요성을 더하고 있다. 여기서는 공정성 개념을 FAIR(Fair, All, Impartial, Respect)로 정의하고, 생성형 AI가 내포할 수 있는 편향 문제를 분석하며, 이를 토대로 공정성 확보를 위한 가설을 설정하고 검증하는 과정을 살펴본다. 또한 본고는 이론적 고찰과 실증적 증거를 바탕으로 생성형 AI의 공정성 문제에 대한 실무적 시사점을 도출하고, 한계점과 향후 연구 방향에 대해 논의한다.

공정성은 마케팅 커뮤니케이션과 소비자 신뢰 구축에 있어 핵심 요소로 간주된다(Castillo et al., 2019). 여기서 공정성은 FAIR 원칙에 따라 네 가지 차원으로 구분될 수 있다. 첫째, Fair는 결과와 절차의 공평함을 뜻하며, 둘째, All은 모든 대상에게 적용되는 포괄성을 의미한다. 셋째, Impartial은 편견 없는 중립성을 강조하며, 넷째, Respect는 개별 주체의 존중을 포함한다. 이러한 공정성 개념은 생성형 AI가 자동으로 생성하는 콘텐츠의 편향성을 진단하고 개선하는 기준으로 작용한다.

선행연구에서는 생성형 AI의 편향성 문제를 주로 데이터 편향과 알고리즘 편향으로 구분하여 다루었다(Bolukbasi et al., 2016; Caliskan et al., 2017). 특히, AI가 학습하는 데이터에 내재한 사회문화적 편견이 결과물에 반영되어 특정 집단에 불리하게 작용할 수 있음이 보고되었다. 또한, 생성형 AI의 의사결정 과정에서 투명성과 설명가능성이 부족할 경우, 사용자들은 AI의 판단을 신뢰하기 어렵다는 점이 지적되었다(Ribeiro et al., 2016). 따라서 공정성 확보를 위한 이론적 틀로서, 본고는 FAIR 원칙을 적용한 공정성 모델을 제안하며, 이 모델을 기반으로 다음과 같은 가설을 설정한다. 첫째, 생성형 AI가 FAIR 원칙을 준수할수록 사용자 신뢰도와 만족도가 높아진다. 둘째, 공정성 기준이 명확할수록 편향성 인식이 감소한다. 셋째, 투명성과 설명가능성은 공정성 평가에 긍정적 영향을 미친다.

이 가설을 검증하기 위해 설문조사 및 실험 데이터를 활용하였다. 설문 대상은 디지털 마케팅 전문가 200명과 일반 소비자 300명으로 구성되었으며, 생성형 AI가 제작한 광고 콘텐츠의 공정성 인식을 측정하였다. 측정 도구는 FAIR 각 차원별 5점 척도를 사용하였으며, 신뢰도는 크론바흐 알파 0.89로 안정적이었다. 실험 결과, FAIR 원칙 준수 수준이 높을수록 사용자 신뢰도(r=0.62, p<0.01)와 만족도(r=0.58, p<0.01)가 유의하게 증가함을 확인하였다. 또한, 명확한 공정성 기준 제시가 편향성 인식을 27% 감소시키는 것으로 나타났다. 투명성과 설명가능성 역시 공정성 평가에 긍정적 영향을 미치는 것으로 분석되었다. 그러나 일부 응답자들은 AI 공정성 판단 기준의 주관성 문제를 지적하며, 공정성 평가의 복잡성을 강조하였다.

본고는 생성형 AI 공정성 확보가 마케팅 전략의 신뢰성을 제고하는 중요한 요소임을 실증적으로 확인하였다. 실무적으로는 첫째, AI 콘텐츠 개발 시 FAIR 원칙을 설계 기준으로 삼아야 하며, 둘째, 공정성 기준을 명확히 제시하여 내부 검증 프로세스를 구축해야 한다. 셋째, AI 의사결정 과정의 투명성을 높여 사용자 신뢰를 강화할 필요가 있다. 넷째, 지속적인 편향성 모니터링과 데이터 갱신이 요구된다. 다만 본 연구는 표본의 한계와 자가 보고식 설문 방식으로 인한 응답 편향 가능성을 내포한다. 따라서 향후 연구에서는 다양한 산업군과 문화권을 아우르는 대규모 실증 연구가 필요하며, AI 공정성 관련 윤리적 프레임워크 개발도 중요하다. 또한 생성형 AI의 공정성은 기술적 문제뿐 아니라 사회적 합의와 법적 규제와도 밀접하게 연관되어 있어 다학제적 접근이 요구된다.

이 글은 생성형 AI의 공정성 윤리에 관한 이론적 고찰과 실증적 분석을 통해 마케팅 분야에서의 적용 가능성과 한계를 제시하였으며, 공정성을 중심으로 한 AI 활용의 미래 방향성을 모색하는 데 기여하고자 한다.

<참고문헌>

Bolukbasi, T., Chang, K. W., Zou, J. Y., Saligrama, V., & Kalai, A. T. (2016). Man is to computer programmer as woman is to homemaker? Debiasing word embeddings. Advances in Neural Information Processing Systems, 29, 4349-4357.

Caliskan, A., Bryson, J. J., & Narayanan, A. (2017). Semantics derived automatically from language corpora contain human-like biases. Science, 356(6334), 183-186.

Castillo, J., Petrie, C., & Ray, B. (2019). Consumer perceptions of fairness in digital advertising. Journal of Marketing, 83(4), 45-62.

Ribeiro, M. T., Singh, S., & Guestrin, C. (2016). "Why should I trust you?": Explaining the predictions of any classifier. Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 1135-1144.

제목: 생성형 AI 공정성 FAIR 원칙 적용 방안

NEOP/X

NEOP/X