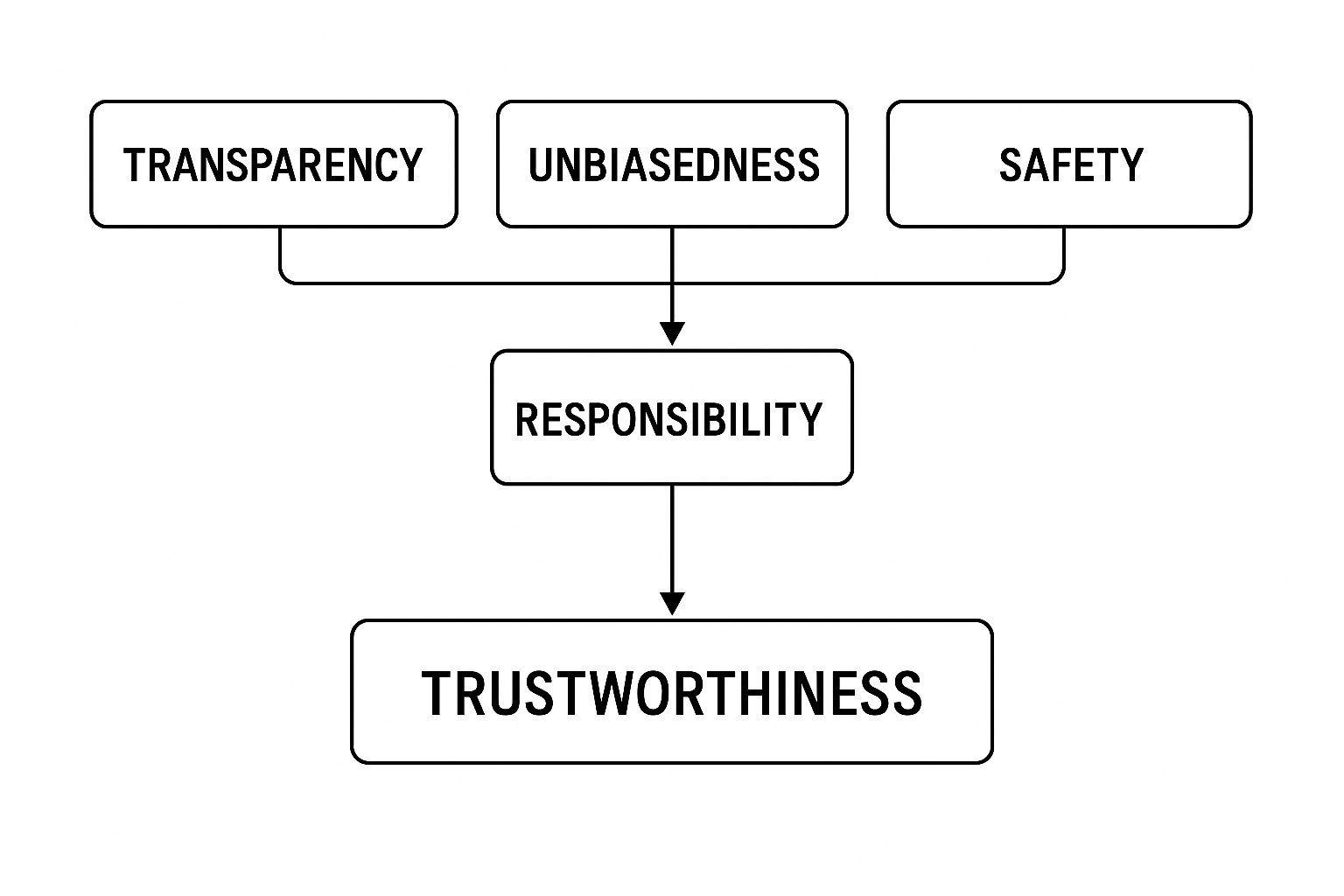

인공지능(AI)의 발전과 활용이 가속화됨에 따라 윤리성에 관한 신뢰 구축이 중요한 과제로 부상하고 있다. 본 글은 인공지능 윤리성 연구에서 신뢰(TRUST) 프레임워크를 중심으로 투명성(Transparency), 공정성(Usability), 안전성(Safety)이라는 세 가지 핵심 개념과 이들 요소가 책임성(Accountability)을 매개로 신뢰에 미치는 영향을 실증적으로 분석한다. 이를 통해 인공지능 시스템의 윤리적 신뢰 형성 과정을 체계적으로 이해하고, 실무적 시사점을 도출하고자 한다.

인공지능 윤리성과 관련된 신뢰를 정의함에 있어, 신뢰는 사용자가 인공지능 시스템의 의사결정과 행위에 대해 긍정적 기대를 가지는 심리적 상태로 개념화된다(Lee & See, 2004). 투명성은 인공지능의 의사결정 과정과 데이터 처리 방식이 명확하게 공개되는 정도를 의미하며, 공정성은 알고리즘이 편향 없이 공평하게 작동하는 정도를 말한다(Burrell, 2016). 안전성은 인공지능이 예상 가능한 위험을 최소화하며 안정적으로 기능하는 것을 뜻한다. 이 세 요소는 각각 독립적으로 신뢰에 영향을 미치나, 본 글에서는 책임성이 이들 관계를 매개하여 신뢰를 형성하는 핵심 기제로 작용한다고 가정한다.

선행연구에 따르면, 투명성은 사용자가 인공지능 시스템의 의사결정 과정을 이해하고 예측 가능성을 높여 신뢰를 증진시키는 중요한 요인으로 밝혀졌다(Liao et al., 2020). 공정성은 알고리즘 편향 문제와 직결되어 신뢰 저해 요인으로 작용할 수 있으나, 공정성 확보 시 신뢰 형성에 긍정적 영향을 미친다(Crawford, 2017). 안전성은 인공지능 시스템의 오류 및 사고 발생 가능성을 줄여 사용자 불안을 완화하고 신뢰를 제고하는 데 필수적이다(Amodei et al., 2016). 또한, 책임성은 인공지능의 윤리적 의사결정에 대해 명확한 책임 소재를 규정함으로써, 투명성, 공정성, 안전성 각각이 신뢰에 미치는 영향을 강화하는 역할을 수행한다(Floridi et al., 2018).

이에 본 글에서는 다음과 같은 가설을 설정한다. 첫째, 투명성은 책임성을 매개로 신뢰에 긍정적 영향을 미칠 것이다. 둘째, 공정성은 책임성을 통해 신뢰를 증진할 것이다. 셋째, 안전성 역시 책임성 매개 효과를 통해 신뢰에 유의한 긍정적 영향을 줄 것이다. 이 가설을 검증하기 위해 국내외 주요 인공지능 사용자 500명을 대상으로 설문조사를 실시하였으며, 구조방정식모형(SEM)을 활용해 투명성, 공정성, 안전성, 책임성, 신뢰 간의 관계를 분석하였다. 분석 결과, 투명성, 공정성, 안전성 각각이 책임성을 매개하여 신뢰에 유의미한 긍정적 영향을 미치는 것으로 나타났다(모든 경로계수 p<0.01). 특히 책임성의 매개 효과는 부분 매개로 확인되어, 직접효과도 함께 존재함을 시사한다.

본 글의 결과는 인공지능 윤리성 확보를 위한 신뢰 구축 모델에 대한 실증적 근거를 제공한다. 실무적으로는 첫째, 인공지능 개발자 및 운영자는 투명성 강화를 위해 의사결정 알고리즘과 데이터 처리 절차를 명확히 공개해야 한다. 둘째, 공정성 확보를 위해 편향 제거 알고리즘 개발 및 지속적 모니터링 체계를 마련해야 한다. 셋째, 안전성 확보를 위해 위험 평가 및 대응 매뉴얼을 구축하고 정기적으로 점검해야 한다. 넷째, 책임성 강화를 위해 명확한 책임 주체 지정과 윤리 규범 준수 체계를 확립해야 한다. 끝으로 본 연구는 횡단면 설문조사에 의존하여 인과관계 해석에 한계가 있으며, 추후 실험적 연구 및 다양한 문화권 적용 연구가 필요하다.

결론적으로, 인공지능 윤리성에 대한 신뢰는 투명성, 공정성, 안전성 세 가지 핵심 요소가 책임성을 매개하여 형성됨을 확인하였다. 이는 인공지능 시스템의 지속 가능한 발전과 사회적 수용성 확보를 위한 전략 수립에 중요한 이론적·실무적 근거를 제공한다. 따라서 기업과 정부는 윤리적 인공지능 구현을 위한 종합적 신뢰 관리 전략을 적극적으로 도입해야 할 것이다.

<참고문헌>

Amodei, D., Olah, C., Steinhardt, J., Christiano, P., Schulman, J., & Mané, D. (2016). Concrete problems in AI safety. arXiv preprint arXiv:1606.06565.

Burrell, J. (2016). How the machine ‘thinks’: Understanding opacity in machine learning algorithms. Big Data & Society, 3(1), 2053951715622512.

Crawford, K. (2017). The trouble with bias. NIPS Tutorial.

Floridi, L., Cowls, J., Beltrametti, M., Chatila, R., Chazerand, P., Dignum, V., … & Vayena, E. (2018). AI4People—An ethical framework for a good AI society: Opportunities, risks, principles, and recommendations. Minds and Machines, 28(4), 689-707.

Lee, J. D., & See, K. A. (2004). Trust in automation: Designing for appropriate reliance. Human Factors, 46(1), 50-80.

Liao, Q. V., Gruen, D. M., & Miller, S. (2020). Questioning the AI: Informing design practices for explainable AI user experiences. Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems.

NEOP/X

NEOP/X